Webスクレイピングとは|概念と初心者向けの使い方

データはビジネスの成長戦略において重要な要素です。データウェアハウスにアクセスし、最大限に活用するには標準化された情報収集方法が必要です。このプラクティスはWebスクレイピングとして知られています。本記事では、Webスクレイピングの概要、Pythonを使用してWebサイトからデータをスクレイピングする方法について解説します。

Webスクレイピングとは

WebスクレイピングとはWebページからデータを抽出することです。情報は収集され、体系的に構造化された形式にエクスポートされます。ユーザーの目的に応じて、Webスクレイピングは手動で行うことも、自動化されたツールを使用して行うこともできます。自動化された方法は高速で安価で効率が高いため、データの抽出に好まれます。

例:数万や数百万の銘柄コードから、銘柄ごと、発行日、情報、および価格を日々収集するなど

Webサイトをスクレイピングするには、オンラインサービス、APIやコードの使用など、いくつかの方法があります。 本記事では、Pythonを使用してWebスクレイピングを実装する方法についてご紹介します。

なぜWebスクレイピングが使われるのか

Webスクレイピングの利点はWorld Wide Webの利点と同じくらい無限です。Webスクレイパーは、オンラインで食べ物を注文したり、オンラインショッピングサイトをスキャンしたり、試合のチケットが入手可能になったらすぐに購入したりするなど、人間ができることなら何でもできます。以下はWebスクレイピングの一般的な用途です。

EコマースWebサイト:Webスクレイパーは様々なeコマースサイトから特定の製品の価格に関連するデータを収集します。

コンテンツアグリゲーター:Webスクレイピングは、ニュースアグリゲーターなどのコンテンツアグリゲーターによって、ユーザーに最新のデータを提供するために広く使用されています。

マーケティングおよび販売キャンペーン:Webスクレイピングを使用して、販売およびマーケティングキャンペーン用の電子メールアドレスや電話番号などのデータを取得します。

検索エンジン最適化(SEO):Webスクレイピングは、SEMRushやMajesticなどのSEOツールで広く使用されており、企業にとって重要な検索キーワードに関するランキングを示します。

機械学習プロジェクトのデータ:機械学習プロジェクトのデータ取得はWebスクレイピングに依存しています。

研究用データ:研究者はこの自動化されたプロセスで時間を節約することにより、研究に役立つデータを収集することができます。

Webスクレイピングは違法なのか合法なのか

インターネット上で公開されているデータをスクレイピングする場合はWebスクレイピングは合法です。しかし、個人データや知的財産をスクレイピングすることは避けるべきです。

Webサイトがスクラップ可能かどうかを知るには、サイトの「robots.txt」ファイルをご確認しください。スクレイピングしたいURLに「/robots.txt」を追加すると、このファイルを見つけることができます。FlipkartのWebサイトをスクレイピングしているとしましょう。「robots.txt」ファイルを表示するためのURLはwww.flipkart.com/robots.txtです。

Pythonによるスクレイピングとは

タスクを実行するためのWebスクレイピングツールがいくつかあります。また、Webスクレイピングをサポートする多くの言語のライブラリがあります。

これらの言語のうち、豊富なライブラリを持つこと、使いやすさや動的型付けなどの特徴により、PythonはWebスクレイピングに最適な言語の1つと見なされています。

以下は最も一般的に使用されているPython3Webスクレイピングライブラリです。

- Beautiful Soup

- Selenium

- Requests

- Lxml

- Mechanical Soup

- Urllib2

Webサイトからデータをスクレイピングする方法

ここでは、PythonのBeautiful Soupを使用して基本的なWebスクレイパーを作成する方法について詳しく説明します。

まず、WebページのHTMLソースコードを取得するには、アクセスしたいWebサイトのURLにHTTPリクエストを送信します。

サーバーは、WebページのHTMLコンテンツを返すことで、このリクエストに応答します。このタスクを実行するには、Pythonでrequestsと呼ばれるサードパーティのHTTPライブラリを使用します。

HTMLコンテンツにアクセスしたら、データを解析します。ほとんどのHTMLデータはネストされていますが、文字列処理だけではデータを抽出することはできません。代わりに、HTMLデータのネスト・ツリー構造を作成することができるパーサーが必要です。そのようなパーサーはhtml5libやlxml などで販売されています。

最後のタスクは、パーサーで生成された解析ツリーをナビゲートして検索することです。このタスクでは、別のサードパーティーのPythonライブラリであるBeautiful SoupというHTMLおよびXMLファイルからデータを取得するための一般的なPythonライブラリを使用します。

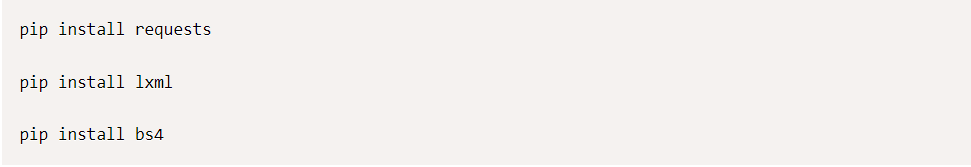

ステップ1:必要なサードパーティライブラリをインポートする

必要なサードパーティライブラリをPython IDEにインポートします。

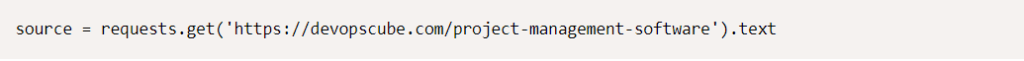

ステップ2:WebサイトからHTMLコンテンツを取得する

リクエストライブラリを使用してWebページからHTMLソース コードを取得するには、次のコードを作成する必要があります。

ステップ3:HTMLコンテンツを解析する

HTMLファイルをBeautiful Soupに解析し、パーサーを指定する必要もあります。ここではlxmlパーサーを使用します。

HTMLコンテンツから生成された解析ツリーを視覚的に表示するには、次のコードを記述します。

ステップ4:解析ツリーをナビゲートして検索する

次に、HTMLコンテンツから有用なデータを抽出します。soupオブジェクトには、プログラムで抽出できる入れ子構造のすべてのデータが含まれています。

Python Webスクレイピングプロジェクトの例

PythonでWebスクレイピングを試すことができる実際のプロジェクトのアイデアをご紹介します。

- ECサイトにおける価格の監視

- 様々なニュースサイトやブログからニュースを収集および提供

- 競合コンテンツの分析

- トレンドコンテンツのためのソーシャルメディア分析

- COVID-19データトラッカー

まとめ

本記事を通して、PythonによるWebスクレイピングとは何かをご理解いただけましたでしょうか。今後のプロジェクトのための開発チームをお探しの場合は、CMC Japanにお気軽にお問い合わせください。当社は従来型のサービスからデジタルトランスフォーメーションやコンサルティングまで、幅広い総合的なITソリューション・サービスを提供します。